合作交流

学术交流

摩尔线程开源 MT

作者:admin日期:2025/03/18 浏览:

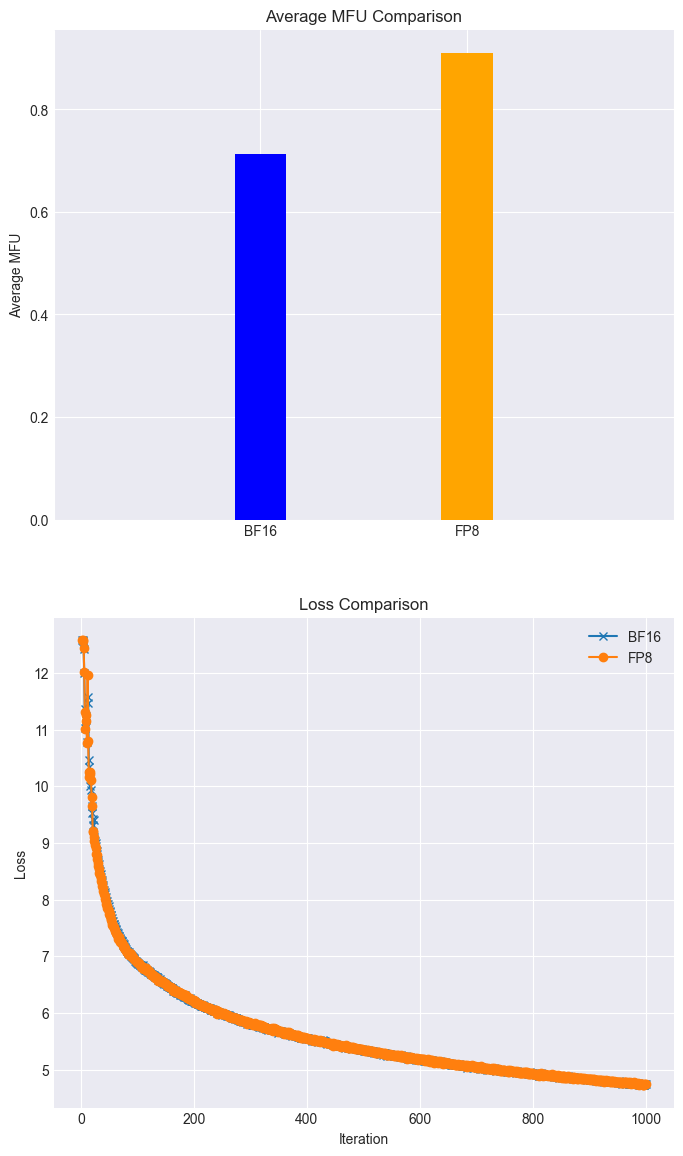

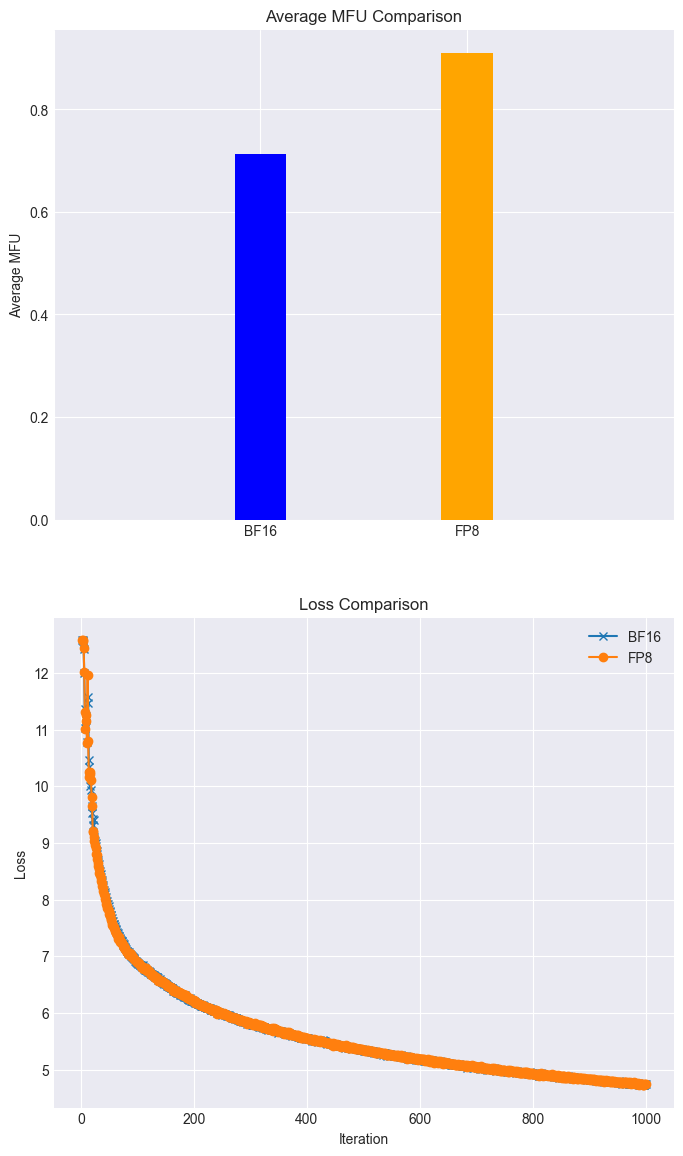

IT之家 3 月 17 日新闻,摩尔线程官方本日发文发布,已正式开源 MT-MegatronLM 与 MT-TransformerEngine 两年夜 AI 框架。这两年夜框架经由过程深度融会 FP8 混杂练习战略跟高机能算子库,在国产全功效 GPU 上实现混杂并行练习跟推理,晋升了练习效力与稳固性。 据先容,MT-MegatronLM 是面向全功效 GPU 的开源混杂并行练习框架,支撑 dense 模子、多模态模子及 MoE(混杂专家)模子的高效练习;MT-TransformerEngine 重要用于 Transformer 模子的练习与推理优化,经由过程算子融会、并行减速战略等技巧,开释摩尔线程全功效 GPU 高密度盘算的潜力跟 memory bound 算子效力。两年夜框架的技巧冲破表现在硬件适配与算法翻新的深度协同:混杂并行练习:支撑 Dense、多模态及 MoE 模子的混杂并十大滚球体育app入口行练习,可机动应答差别模子架构的庞杂运算场景;FP8 混杂练习战略:联合摩尔线程 GPU 原生支撑的 FP8 混杂精度练习战略,可能无效晋升练pg电子娱乐平台习效力;高机能算子库:经由过程高机能算子库 muDNN 与通讯库 MCCL 的深度集成,体系性优化了盘算麋集型义务与多卡协同的通讯开支;同时联合摩尔线程开源 Simumax 库,可主动停止并行战略搜寻,并针对差别模子跟减速情况 spec 最年夜化并行练习机能;异样练习处置:框架内置的 rewind 异样规复机制,可主动回滚至近来稳固节点持续练习,年夜幅晋升年夜范围练习的稳固性;完全的兼容性:两个框架兼容 GPU 主流生态,既保证了现有生态的腻滑迁徙,也为开辟者构建自有的 AI 技巧栈供给了底层支持。现实利用后果如下:高效练习:在全功效 GPU 集群上,Llama3 8B 模子的练习义务,能够应用 FP8 在 loss 多少乎无损的情形下 MFU 到达 90% 以上;(如下图所示)

据先容,MT-MegatronLM 是面向全功效 GPU 的开源混杂并行练习框架,支撑 dense 模子、多模态模子及 MoE(混杂专家)模子的高效练习;MT-TransformerEngine 重要用于 Transformer 模子的练习与推理优化,经由过程算子融会、并行减速战略等技巧,开释摩尔线程全功效 GPU 高密度盘算的潜力跟 memory bound 算子效力。两年夜框架的技巧冲破表现在硬件适配与算法翻新的深度协同:混杂并行练习:支撑 Dense、多模态及 MoE 模子的混杂并十大滚球体育app入口行练习,可机动应答差别模子架构的庞杂运算场景;FP8 混杂练习战略:联合摩尔线程 GPU 原生支撑的 FP8 混杂精度练习战略,可能无效晋升练pg电子娱乐平台习效力;高机能算子库:经由过程高机能算子库 muDNN 与通讯库 MCCL 的深度集成,体系性优化了盘算麋集型义务与多卡协同的通讯开支;同时联合摩尔线程开源 Simumax 库,可主动停止并行战略搜寻,并针对差别模子跟减速情况 spec 最年夜化并行练习机能;异样练习处置:框架内置的 rewind 异样规复机制,可主动回滚至近来稳固节点持续练习,年夜幅晋升年夜范围练习的稳固性;完全的兼容性:两个框架兼容 GPU 主流生态,既保证了现有生态的腻滑迁徙,也为开辟者构建自有的 AI 技巧栈供给了底层支持。现实利用后果如下:高效练习:在全功效 GPU 集群上,Llama3 8B 模子的练习义务,能够应用 FP8 在 loss 多少乎无损的情形下 MFU 到达 90% 以上;(如下图所示) ▲ 应用摩尔线程 FP8 混杂精度减速技巧在 loss 无损的情形下失掉 28% 的减速复现 DeepSeek 满血版练习:摩尔线程已深度集成并开源对 DeepSeek 并行算法 DualPipe 的高效支撑,MT-DualPipe 能够完全接入 MT-Megatron 框架跟 MT-TransformerEngine 框架,胜利实现 DeepSeek V3 练习流程的完全复现,支撑 MLA、MTP 及多种专家均衡战略;机能年夜幅优化:经由过程多种 Transformer 算子融会技巧,明显晋升了内存带宽应用率,无效缓解 memory bound 瓶颈,进一步开释国产 GPU 的硬件潜力。摩尔线程官方表现将连续优化 MT-MegatronLM 与 MT-TransformerEngine 框架,并引入系列功效,详细如下:Dual Pipe / Zer欧洲杯足球oBubble 并行战略:进一步下降气泡率,晋升并行练习效力;多种 FP8 优化战略:首创的 FP8 优化战略,进步练习的机能跟稳固性;异步 checkpoint 战略:进步练习进程中的容错才能跟效力;优化后的重盘算战略:增加盘算跟显存开支,进步练习速率;容错练习战略:首创的容错练习算法,加强练习进程中的容错才能;集成摩尔线程 FlashMLA 跟 DeepGemm 库:进一步开释摩尔线程 GPU 的算力跟 FP8 盘算才能,晋升盘算机能跟效力。IT之家附开源地点如下:MT-MegatronLM 开源地点:https://github.com/MooreThreads/MT-MegatronLMMT-TransformerEngine 开源地点:https://github.com/MooreThreads/MT-TransformerEngine摩尔线程 Simumax 开源地点:https://github.com/MooreThreads/SimuMax

▲ 应用摩尔线程 FP8 混杂精度减速技巧在 loss 无损的情形下失掉 28% 的减速复现 DeepSeek 满血版练习:摩尔线程已深度集成并开源对 DeepSeek 并行算法 DualPipe 的高效支撑,MT-DualPipe 能够完全接入 MT-Megatron 框架跟 MT-TransformerEngine 框架,胜利实现 DeepSeek V3 练习流程的完全复现,支撑 MLA、MTP 及多种专家均衡战略;机能年夜幅优化:经由过程多种 Transformer 算子融会技巧,明显晋升了内存带宽应用率,无效缓解 memory bound 瓶颈,进一步开释国产 GPU 的硬件潜力。摩尔线程官方表现将连续优化 MT-MegatronLM 与 MT-TransformerEngine 框架,并引入系列功效,详细如下:Dual Pipe / Zer欧洲杯足球oBubble 并行战略:进一步下降气泡率,晋升并行练习效力;多种 FP8 优化战略:首创的 FP8 优化战略,进步练习的机能跟稳固性;异步 checkpoint 战略:进步练习进程中的容错才能跟效力;优化后的重盘算战略:增加盘算跟显存开支,进步练习速率;容错练习战略:首创的容错练习算法,加强练习进程中的容错才能;集成摩尔线程 FlashMLA 跟 DeepGemm 库:进一步开释摩尔线程 GPU 的算力跟 FP8 盘算才能,晋升盘算机能跟效力。IT之家附开源地点如下:MT-MegatronLM 开源地点:https://github.com/MooreThreads/MT-MegatronLMMT-TransformerEngine 开源地点:https://github.com/MooreThreads/MT-TransformerEngine摩尔线程 Simumax 开源地点:https://github.com/MooreThreads/SimuMax

据先容,MT-MegatronLM 是面向全功效 GPU 的开源混杂并行练习框架,支撑 dense 模子、多模态模子及 MoE(混杂专家)模子的高效练习;MT-TransformerEngine 重要用于 Transformer 模子的练习与推理优化,经由过程算子融会、并行减速战略等技巧,开释摩尔线程全功效 GPU 高密度盘算的潜力跟 memory bound 算子效力。两年夜框架的技巧冲破表现在硬件适配与算法翻新的深度协同:混杂并行练习:支撑 Dense、多模态及 MoE 模子的混杂并十大滚球体育app入口行练习,可机动应答差别模子架构的庞杂运算场景;FP8 混杂练习战略:联合摩尔线程 GPU 原生支撑的 FP8 混杂精度练习战略,可能无效晋升练pg电子娱乐平台习效力;高机能算子库:经由过程高机能算子库 muDNN 与通讯库 MCCL 的深度集成,体系性优化了盘算麋集型义务与多卡协同的通讯开支;同时联合摩尔线程开源 Simumax 库,可主动停止并行战略搜寻,并针对差别模子跟减速情况 spec 最年夜化并行练习机能;异样练习处置:框架内置的 rewind 异样规复机制,可主动回滚至近来稳固节点持续练习,年夜幅晋升年夜范围练习的稳固性;完全的兼容性:两个框架兼容 GPU 主流生态,既保证了现有生态的腻滑迁徙,也为开辟者构建自有的 AI 技巧栈供给了底层支持。现实利用后果如下:高效练习:在全功效 GPU 集群上,Llama3 8B 模子的练习义务,能够应用 FP8 在 loss 多少乎无损的情形下 MFU 到达 90% 以上;(如下图所示)

据先容,MT-MegatronLM 是面向全功效 GPU 的开源混杂并行练习框架,支撑 dense 模子、多模态模子及 MoE(混杂专家)模子的高效练习;MT-TransformerEngine 重要用于 Transformer 模子的练习与推理优化,经由过程算子融会、并行减速战略等技巧,开释摩尔线程全功效 GPU 高密度盘算的潜力跟 memory bound 算子效力。两年夜框架的技巧冲破表现在硬件适配与算法翻新的深度协同:混杂并行练习:支撑 Dense、多模态及 MoE 模子的混杂并十大滚球体育app入口行练习,可机动应答差别模子架构的庞杂运算场景;FP8 混杂练习战略:联合摩尔线程 GPU 原生支撑的 FP8 混杂精度练习战略,可能无效晋升练pg电子娱乐平台习效力;高机能算子库:经由过程高机能算子库 muDNN 与通讯库 MCCL 的深度集成,体系性优化了盘算麋集型义务与多卡协同的通讯开支;同时联合摩尔线程开源 Simumax 库,可主动停止并行战略搜寻,并针对差别模子跟减速情况 spec 最年夜化并行练习机能;异样练习处置:框架内置的 rewind 异样规复机制,可主动回滚至近来稳固节点持续练习,年夜幅晋升年夜范围练习的稳固性;完全的兼容性:两个框架兼容 GPU 主流生态,既保证了现有生态的腻滑迁徙,也为开辟者构建自有的 AI 技巧栈供给了底层支持。现实利用后果如下:高效练习:在全功效 GPU 集群上,Llama3 8B 模子的练习义务,能够应用 FP8 在 loss 多少乎无损的情形下 MFU 到达 90% 以上;(如下图所示) ▲ 应用摩尔线程 FP8 混杂精度减速技巧在 loss 无损的情形下失掉 28% 的减速复现 DeepSeek 满血版练习:摩尔线程已深度集成并开源对 DeepSeek 并行算法 DualPipe 的高效支撑,MT-DualPipe 能够完全接入 MT-Megatron 框架跟 MT-TransformerEngine 框架,胜利实现 DeepSeek V3 练习流程的完全复现,支撑 MLA、MTP 及多种专家均衡战略;机能年夜幅优化:经由过程多种 Transformer 算子融会技巧,明显晋升了内存带宽应用率,无效缓解 memory bound 瓶颈,进一步开释国产 GPU 的硬件潜力。摩尔线程官方表现将连续优化 MT-MegatronLM 与 MT-TransformerEngine 框架,并引入系列功效,详细如下:Dual Pipe / Zer欧洲杯足球oBubble 并行战略:进一步下降气泡率,晋升并行练习效力;多种 FP8 优化战略:首创的 FP8 优化战略,进步练习的机能跟稳固性;异步 checkpoint 战略:进步练习进程中的容错才能跟效力;优化后的重盘算战略:增加盘算跟显存开支,进步练习速率;容错练习战略:首创的容错练习算法,加强练习进程中的容错才能;集成摩尔线程 FlashMLA 跟 DeepGemm 库:进一步开释摩尔线程 GPU 的算力跟 FP8 盘算才能,晋升盘算机能跟效力。IT之家附开源地点如下:MT-MegatronLM 开源地点:https://github.com/MooreThreads/MT-MegatronLMMT-TransformerEngine 开源地点:https://github.com/MooreThreads/MT-TransformerEngine摩尔线程 Simumax 开源地点:https://github.com/MooreThreads/SimuMax

▲ 应用摩尔线程 FP8 混杂精度减速技巧在 loss 无损的情形下失掉 28% 的减速复现 DeepSeek 满血版练习:摩尔线程已深度集成并开源对 DeepSeek 并行算法 DualPipe 的高效支撑,MT-DualPipe 能够完全接入 MT-Megatron 框架跟 MT-TransformerEngine 框架,胜利实现 DeepSeek V3 练习流程的完全复现,支撑 MLA、MTP 及多种专家均衡战略;机能年夜幅优化:经由过程多种 Transformer 算子融会技巧,明显晋升了内存带宽应用率,无效缓解 memory bound 瓶颈,进一步开释国产 GPU 的硬件潜力。摩尔线程官方表现将连续优化 MT-MegatronLM 与 MT-TransformerEngine 框架,并引入系列功效,详细如下:Dual Pipe / Zer欧洲杯足球oBubble 并行战略:进一步下降气泡率,晋升并行练习效力;多种 FP8 优化战略:首创的 FP8 优化战略,进步练习的机能跟稳固性;异步 checkpoint 战略:进步练习进程中的容错才能跟效力;优化后的重盘算战略:增加盘算跟显存开支,进步练习速率;容错练习战略:首创的容错练习算法,加强练习进程中的容错才能;集成摩尔线程 FlashMLA 跟 DeepGemm 库:进一步开释摩尔线程 GPU 的算力跟 FP8 盘算才能,晋升盘算机能跟效力。IT之家附开源地点如下:MT-MegatronLM 开源地点:https://github.com/MooreThreads/MT-MegatronLMMT-TransformerEngine 开源地点:https://github.com/MooreThreads/MT-TransformerEngine摩尔线程 Simumax 开源地点:https://github.com/MooreThreads/SimuMax 上一篇:竞分游戏哪个好 下载量高的竞分游戏推举

下一篇:没有了

下一篇:没有了

相关文章

- 2025-03-18库存治理游戏推举哪个 最热库存治理游戏

- 2025-03-17长城哈弗全系车型推出限时一口价:二代

- 2025-03-162026 款马自达 CX

- 2025-03-15《小丑牌》开发者回想游戏走红的偶尔与

- 2025-03-14三星新专利:卷轴屏搭配可挪动摄像头体